英特尔承诺明年的至强将在内存、IO通道等方面挑战AMD

此外,芯片巨头还发布了关于E核数据中心芯片的更多消息。

英特尔日前在Hot Chips 2023大会上公布了下一代至强处理器即将迎来的更多架构变化,包括对内存子系统和IO连接的改进。

虽然x86巨头的第五代至强Scalable处理器还有几个月时间才会正式上市,但英特尔已经在展望接下来的Sierra Forest和Granite Rapids等至强新成员,而且似乎很有信心在内存和IO方面力压多年来的竞争对手AMD。

英特尔的现款至强Scalabe处理器(代号为Sapphire Rapids)最高可支持8条DDR5 DRAM通道、速度为4800 MT/秒,以及80条PCIe 5.0/CXL 1.1连接通道。相比之下,AMD Epyc 4平台则分别提供12条DDR5通道和128条PCIe通道。

英特尔的下一代至强(可能是第六代)也将转向12条DDR5/MCR DRAM DIMM通道配置,并提供136条PCIe 5.0/CXL 2.0接口通道。此外,英特尔还提到至强处理器系列将支持每通道双DIMM(2DPC)配置。去年11月,AMD曾在将Epyc 4推向12条内在通道时遭遇到一些问题。

多路复用器组合列(MCR)DIMM的亮点,在于承诺带来远超传统DDR5 DRAM的内存带宽。英特尔曾在今年3月的演示中公布了预生产的Granite Rapids至强,它能以8800 MT/秒的速度接入MCR模块。这样的成绩几乎达到现有服务器平台上现代DDR5速度(4400至4800 MT/秒)的2倍。

英特尔研究员Ronak Singhal在Hot Chips会前的简报中表示,“从Sapphire Rapids到这一代新平台,我们的内存带宽将提高近3倍。”

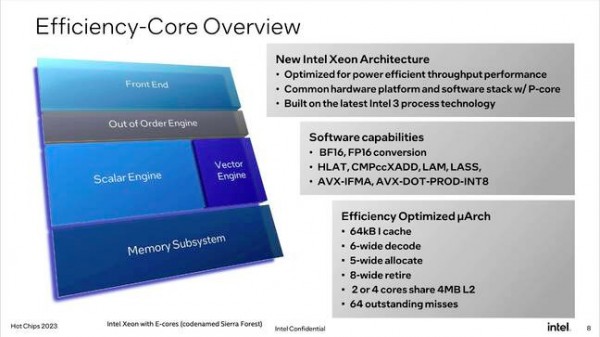

据了解,英特尔Sierra Forest至强当中使用的E核心将采用针对效率和吞吐量进行优化的精简核心架构。

虽然目前关于Sierra Forest的详细信息仍然有限,但已经知晓的情况是该处理器将拥有最多144个核心,且提供单插槽与双插槽配置。

我们还了解到,英特尔将提供该芯片的缓存优化版本,每4 MB的L2池对应2个或4个核心。Singhal解释道,“有些客户希望核心数量少点、但每核性能更强一些。在这种情况下,那就是由2个核心共享这4 MB L2。”

在另一方面,对于需要运行大量浮点运算(包括AI和机器学习)的朋友,Sierra Forest将支持BF16和FP16加速。据我们了解,这源自本代至强包含的AVX10支持能力。

在性能方面,英特尔也对其E核心做出了相当大胆的承诺。在机架层面,英特尔称Sierra Forest与Sapphire Rapids相比,所提供的线程数量约为2.5倍、每瓦性能可提高240%。

Singhal表示,“而且在最新的至强处理器上,不仅仅是线程密度提高了,每线程性能也几乎完全不受影响。”

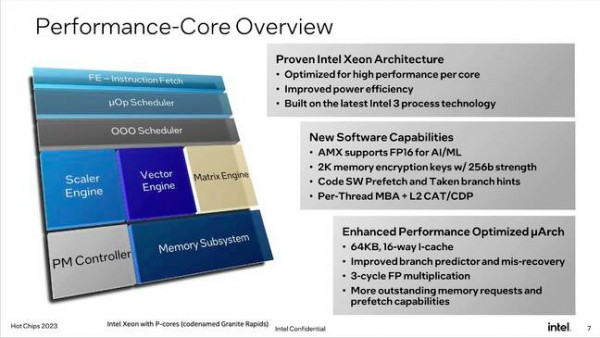

英特尔表示,与Sapphire Rapids相比,配备P核的Granite Rapids至强将提供更多计算核心与更强的AMX性能。

至于倾力打造的P核Granite Rapids芯片,英特尔承诺其较Sapphire Rapids拥有更高的核心数量,同时改进了AMX引擎并扩展了对AI/机器学习工作负载中的FP16计算支持。但英特尔并未透露最终产品具体会包含多少个核心。

英特尔本次公布的其他细节,还包括更大的内存加密密钥、经过改进的预取和分支预测,以及更快的浮点乘法运算速度等。

根据英特尔透露的消息,Sierra Forest计划于“2024年上半年”推出;而Granite Rapids也将在“此后不久”与大家见面。

好文章,需要你的鼓励

EVOLVE 2025| 推进AI从PoC到“生产线” Cloudera开辟了这样一条路!

据质量、数据访问权限、安全合规、跨环境调度、成本控制构成了企业级AI生产环境的多维挑战。

哈工大和360研究团队突破AI“偷懒思维“:让人工智能真正听懂复杂指令的秘密武器

哈工大和360研究团队联合开发了Light-IF框架,成功解决了大型语言模型在处理复杂指令时的"偷懒思维"问题。该框架通过教AI学会"预览和自检"的工作方式,显著提升了AI对多重约束条件任务的处理能力。Light-IF-32B模型在四个权威测试平台上均取得最佳成绩,超越了多个知名大型模型。研究团队已开源相关模型和代码,为AI助手的发展开辟了新方向。

ChatGPT-5如何加速人类认知能力的衰退

ChatGPT-5的统一架构消除了用户选择模型的认知摩擦,自动路由查询到快速或深度思考模式,使用户失去问题分类和框架构建的基本技能。这种无形的认知外包加上商业订阅模式,创造了"认知供应商锁定"效应。专家面临技能衰退和能力错觉的双重威胁,需要通过意识、理解、接受、问责四个维度建立认知抵抗力,主动维护人类独特的思维能力。

T-Tech实验室让AI机器人能用眼看能动手,如同训练一个聪明学徒完成复杂任务

T-Tech实验室开发出革命性的VL-DAC训练方法,让AI机器人能够通过观看简单模拟环境学会复杂的现实世界技能。该方法将AI的"观察思考"与"实际行动"分开训练,避免了传统方法需要复杂参数调整的问题。实验证明,AI在导航、卡牌游戏等简化环境中训练后,在真实世界的游戏控制、空间规划和网页操作任务中性能分别提升50%、5%和2%,为降低AI开发成本开辟了新路径。

EVOLVE 2025| 推进AI从PoC到“生产线” Cloudera开辟了这样一条路!

EVOLVE 2025|Cloudera重塑数据底座“基本盘” 加速AI“增长飞轮”

ChatGPT-5如何加速人类认知能力的衰退

从TB级数据到智能洞察:真实AI可观测性架构实践

大科技公司AI投资回报差异巨大的原因

高通高管详述汽车、物联网等领域增长计划

ChatGPT重新将4o作为选项带回,因为用户对其念念不忘

Meta牵手Pimco和Blue Owl完成290亿美元数据中心融资

NASA联手谷歌开发AI医疗助手保障火星宇航员健康

OpenAI采用新数据类型MXFP4,推理成本降低75%

苹果将在iOS和macOS中集成OpenAI GPT-5模型

扎克伯格谈个人超级智能:AI将如何重塑人类未来

成本打到6万以下,手把手教你用4路锐炫显卡+至强W跑DeepSeek

天翼云CPU实例部署DeepSeek-R1模型最佳实践

MWC 2025:英特尔展示基于至强6处理器的基础网络设施

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

英特尔至强6新品发布,能为数据中心带来哪些改变?

英特尔推出具备高性能和能效的以太网解决方案

英特尔推出搭载至强6处理器的卓越AI和网络解决方案

HPE Gen12:英特尔至强6加持,数据中心和边缘计算的“新宠”

英特尔Gaudi 2D AI加速器为DeepSeek Janus Pro模型提供加速

英特尔:旗下的“主打”18A 产品将于2025 年下半年投产